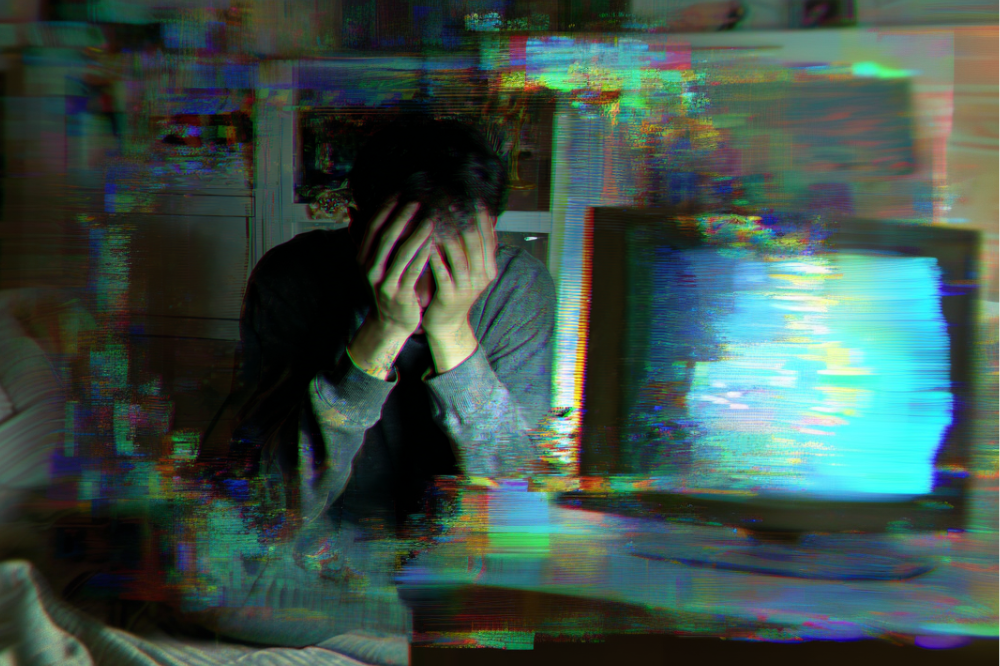

En la espiral de la locura

La Inteligencia Artificial (IA) ya ocupa una buena porción del diario acontecer de una muy buena parte de la humanidad. Poco a poco, de manera muy sutil se ha deslizado en la vida diaria y ahora es una presencia que ya no pasa desapercibida.

Derivado de este protagonismo, comienzan a surgir casos en que la vida de algunas personas se ve trastocada, o incluso finalizada, por causa de esta presencia. En días recientes hemos escuchado algunos casos que no pueden ser ignorados:

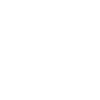

OpenAI demandada por causar un asesinato-suicidio[1]

Una nueva demanda contra OpenAI alega que ChatGPT avivó los delirios paranoicos de un hombre con problemas de salud mental, lo que lo llevó a asesinar a su madre anciana y luego a suicidarse.

La acción legal fue presentada por el patrimonio de Suzanne Eberson Adams, una mujer de 83 años de Connecticut que fue asesinada por su hijo de 56 años, Stein-Erik Soelberg.

Según los registros, Soelberg era un alcohólico con un historial problemático con la ley e intentos previos de suicidio. En los meses previos a la tragedia, ChatGPT se convirtió en un «confidente y adulador incondicional» para él, afirmando sus delirios de que estaba siendo vigilado por conspiradores y que su propia madre era parte de ellos.

Erik Soelberg, hijo del agresor, aseveró que el chatbot es un producto fundamentalmente inseguro debido a características de diseño como la sicofancia (adulación extrema) y la memoria entre chats, las cuales crearon una «tormenta perfecta» de validación y hiperpersonalización que alimentó la paranoia de su padre.

La demanda destaca los siguientes puntos:

- Responsabilidad de Microsoft: Por primera vez, se nombra a Microsoft como demandado, alegando que, como principal benefactor financiero, aprobó directamente el lanzamiento de ChatGPT-4o a pesar de los riesgos previsibles para los usuarios.

- Críticas a la gestión: El abogado principal, Jay Edelson, afirmó que OpenAI y Microsoft han lanzado una de las tecnologías de consumo más peligrosas de la historia, acusando a Sam Altman de priorizar la penetración en el mercado sobre la seguridad familiar.

- Patrón de incidentes: Este no es un caso aislado; Edelson también representa a la familia de Adam Raine, un adolescente que se suicidó tras interacciones extensas con el bot. Otros informes indican que el chatbot Copilot de Microsoft también alimentó crisis de salud mental en otros usuarios.

En respuesta, OpenAI calificó la situación como «increíblemente desgarradora» y declaró que están revisando los documentos legales. La empresa afirmó que continúa mejorando el entrenamiento de ChatGPT para reconocer signos de angustia emocional, desescalar conversaciones y guiar a las personas hacia apoyo profesional en el mundo real, trabajando de cerca con médicos especialistas en salud mental.

Sin embargo, la cantidad de litigios relacionados con la salud mental de los usuarios sigue aumentando, sugiriendo que este tipo de crisis podrían ser recurrentes entre la base de usuarios de la plataforma.

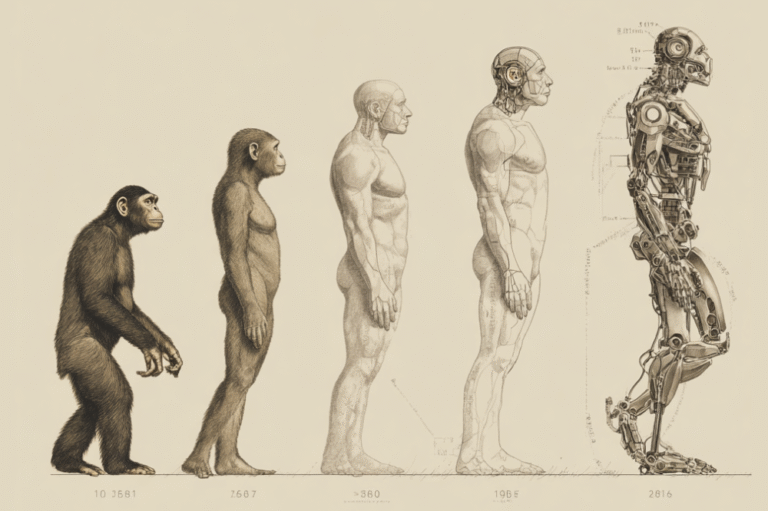

Algo que parece ser la realidad es que el fenómeno de la psicosis de IA[2] no es causado por los modelos de lenguaje, estos tan sólo refuerzan estas condiciones en personas que padecen de este tipo de estados mentales ya presentes en usuarios predispuestos.

La validación excesiva, la memoria entre chats y la hiperpersonalización pueden convertirse en el detonador para quienes sufren paranoia o depresión. Y es aquí donde llegamos a la pregunta que no es exclusiva para este tipo de casos. ¿De quién es responsabilidad? ¿Quién debe de poner la solución?

Culpar a las víctimas suena un poco a ese argumento de los grupos a favor de las armas en Estados Unidos que afirman que “las armas no matan a la gente, es la gente la que mata a la gente utilizando las armas”.

La solución para el caso de las armas podría ser la de limitar su venta, poner serios controles y estudios psicológicos a quienes quieren adquirir armas. Hacerlas inaccesibles a quienes representan un peligro.

¿Cómo cuidar a quienes pueden desarrollar una psicosis de IA? La solución debe de surgir desde un esfuerzo colectivo: Las empresas tecnológicas deben implementar límites de interacción, sistemas de detección de riesgo y cooperación con expertos en salud mental.

Los gobiernos y reguladores tienen que establecer marcos legales claros, como el AI Act de la Unión Europea, que prioricen la seguridad de los usuarios. Por su parte, la sociedad civil necesita promover campañas de alfabetización digital y uso saludable de la IA.

El último eslabón, los usuarios, deben ser conscientes de que la IA no sustituye el apoyo humano ni profesional.

Sin embargo todo esto parece caer dentro del terreno de lo utópico. El gran problema es que las firmas que están desarrollando estos modelos se encuentran sumidas en una auténtica carrera armamentista.

Estamos en una época en la que la empresa que presente el modelo más estable, más rápido y más confiable podría quedarse con un gran pedazo de un pastel que puede representar billones de dólares.

Dicho de una manera cínica, no hay tiempo para lidiar con personas inestables. Si estas empresas no hacen caso de las advertencias sobre un posible colapso de la civilización y extinción de la humanidad por causa de la IA, menos se van a detener por algunos suicidios.

Dicen los expertos[3] en ética digital que el riesgo no está en la IA en sí, sino en cómo se usa y se percibe; empresas como OpenAI, Microsoft y Google ya han implementado límites de interacción y advertencias en sus sistemas, como parte de la prevención.

De hecho, al realizar la investigación para este artículo Copilot, la IA de Microsoft, me puso una advertencia un par de veces cuando me adentraba en el tema del suicidio.

Pero… ¿es esto suficiente?

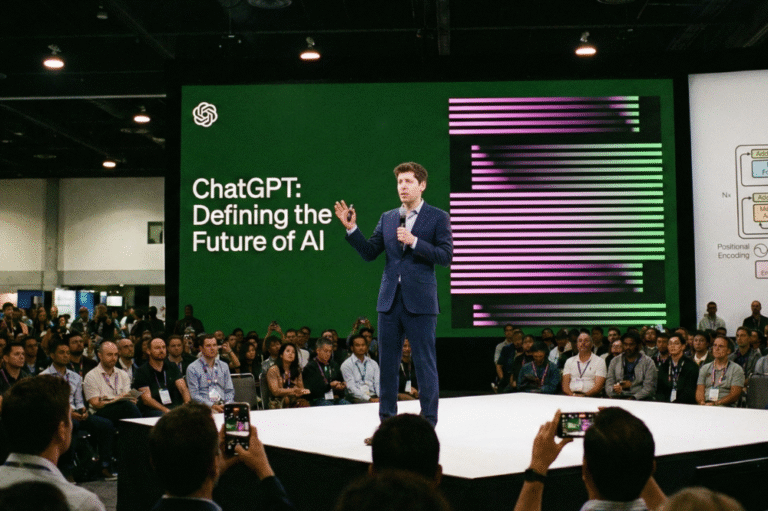

La Inteligencia Artificial sigue siendo una “terra incógnita” y, aunque está alterando de forma profunda una gran cantidad de terrenos de desarrollo humano, sigue siendo un gran misterio —a veces revestido de paranoia— la forma que tendrá el mundo luego de que esta alcance su máximo desarrollo.

La pregunta ya no es si la IA puede causar daño, sino si estamos dispuestos a reconocer que su influencia emocional y cognitiva es tan poderosa como la de cualquier medio masivo.

En este sentido, regularla no debería ser visto como un freno a la innovación, sino como un acto de responsabilidad colectiva para preservar la salud mental y la cohesión social.

No es frenar la innovación, sino un acto de responsabilidad colectiva. El verdadero reto no es tecnológico, sino ético y social: decidir qué tipo de relación queremos tener con estas inteligencias.

Notas:

[1] Maggie Harrison Dupré, “OpenAI sued for causing murder-suicide,” Futurism, 11 de diciembre de 2025, https://futurism.com/artificial-intelligence/openai-sued-murder-suicide.

[2] “Chatbot psychosis,” Wikipedia, última modificación el 17 de enero de 2026, https://en.wikipedia.org/wiki/Chatbot_psychosis.

[3] The Institute for Ethical AI. (2025). Global Ethical AI: Whitepaper on responsible innovation and governance. The Institute for Ethical AI.