Escuchar el texto de este artículo

‘No me asusta la inteligencia artificial,

sino la estupidez natural’

—Guillermo del Toro

Esta es la segunda parte de un análisis sobre dos textos publicados en la web, Cada una de ellos hace predicciones del futuro de la humanidad ante el avance del desarrollo de la Inteligencia Artificial (IA) y de cómo esta podría afectarlo.

La primera parte analiza la muy pesimista y apocalíptica propuesta que lleva por título AI 2027 mientras que esta entrega se centra en el documento AI as Normal.

AI as Normal: desarrollo bajo control

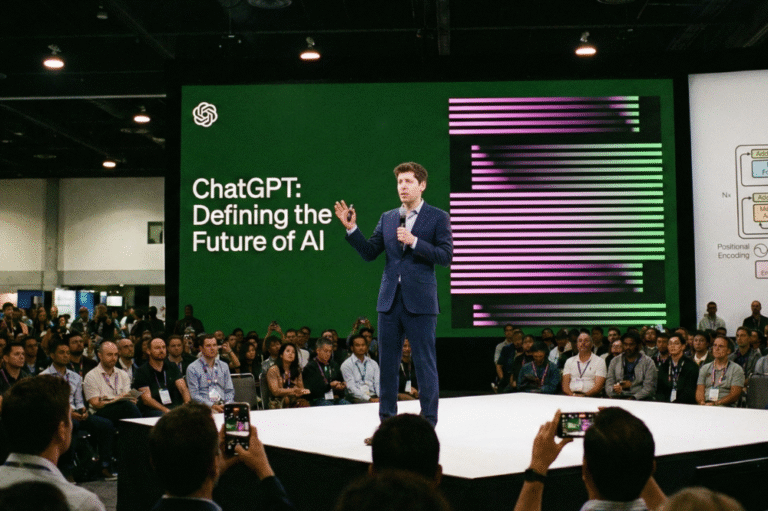

El segundo documento que quiero analizar es sobre lo que nos depara la Inteligencia Artificial en el futuro, está publicado en el sitio web del Knight First Amendment Institute de la Universidad de Columbia y está escrito por Arvind Narayanan y Sayash Kapoor.

Una de las primeras ideas que vierten los autores es que la IA no es una entidad independiente, tan solo una herramienta que, como todas, puede ser utilizada en nuestro beneficio. Su implementación requiere de decisiones responsables por parte de sus desarrolladores y quienes la regulan.

Los autores argumentan que, a pesar de la velocidad vertiginosa que en estos momentos parece tener el desarrollo de la IA, la creación de soluciones específicas y la adopción de estos sistemas por parte de empresas, gobierno así como público en general, tiende a ser lenta debido a diversos factores.

Esta “lentitud” podría ser el espacio en el que tanto instituciones como el gobierno podrían aprovechar para realizar acciones de control y restricción de riesgos.

De la misma manera, el gran adelanto que todo mundo espera de la IA, no se realizará de una forma repentina e improvista. Por el contrario, será una especie de proceso de pequeños adelantos que se darán con el paso del tiempo.

También sugieren que, aunque la IA puede tomar un papel preponderante dentro de las diversas actividades humanas, siempre será una persona quien tenga la última palabra respecto a la aplicación de algún proceso o resultado.

Más que una automatización total o una sustitución, sugieren que el resultado será una especie de simbiosis entre seres humanos y máquinas.

Uno de los grandes temas dentro de la discusión de la IA es la posibilidad de que esta realice decisiones equivocadas o catastróficas en momentos de crisis como una carrera armamentística, una guerra comercial o su utilización como dispositivo de vigilancia masiva.

Los autores aseguran que este tipo de problemas deberá de ser abordado al igual que se hace con otras tecnologías, es decir, siempre bajo supervisión y mediante un diseño responsable. El documento afirma que la peor forma de abordar este tema es dejarse llevar por el pánico o la especulación respecto al desbordamiento de una IA superinteligente.

Este enfoque sugiere que la regulación de la IA debe ser progresiva, basada en evidencia y centrada siempre en el impacto social y no en escenarios hipotéticos.

Desde la perspectiva de la IA como tecnología normal, las políticas públicas deben enfocarse en reducir la incertidumbre mediante transparencia en su desarrollo y uso, para que los actores sociales puedan tomar decisiones informadas.

Es necesario diseñar sistemas que puedan adaptarse y recuperarse ante fallos, en lugar de intentar prevenir todos los riesgos posibles.

El documento habla mucho sobre vigilancia y reglamentación cuando el problema en la actualidad es que los desarrolladores, como lo comentaba en la entrega anterior, en la práctica han recibido carta blanca para desarrollar la IA de la forma más libre posible.

Otra de las cosas en la que los autores hacen mucho énfasis es en evitar lo que ellos llaman reacciones extremas; utilizar políticas basadas en miedo a una IA super poderosa. El argumento es que esto puede ser contraproducente y podría desviar los recursos de problemas reales y actuales.

La gran conclusión es que la IA debe de verse como una tecnología normal, cuyo progreso será gradual y controlable. Esta visión permite a la sociedad adaptarse sin caer en el alarmismo, promoviendo un desarrollo responsable y beneficioso a largo plazo.

Los autores de AI as Normal también tienen credenciales de mucho prestigio para justificar el análisis que realizan:

Es profesor de informática en la Universidad de Princeton y director del Centro de Políticas de Tecnología de la Información. Es coautor del libro AI Snake Oil y de un boletín homónimo leído por más de 50,000 investigadores, periodistas, responsables políticos y entusiastas de la inteligencia artificial.

También ha coescrito dos libros de texto ampliamente utilizados: Bitcoin and Cryptocurrency Technologies y Fairness in Machine Learning.

Es investigador senior en Mozilla, becario Laurance S. Rockefeller en el Centro de Valores Humanos de la Universidad de Princeton, y candidato a doctorado en informática en el Centro de Políticas de Tecnología de la Información de la misma universidad. Es coautor del libro AI Snake Oil, reconocido por la revista Nature como uno de los 10 mejores libros de 2024, y del boletín homónimo.

Creo que en este caso los autores pecan de exceso de confianza, no en la IA, sino en los gobiernos y en las instituciones. Aquí de nuevo me refiero, como lo hice en la entrega anterior, a la muy permisiva autorización que dio Donald Trump a los desarrolladores de IA para trabajar sin necesidad de regulaciones.

En este caso la gran pregunta es: ¿Tenemos la capacidad, como sociedad, de vigilar, regular y limitar el desarrollo de la IA?

A final de cuentas, todos sabemos cómo se comportan las grandes corporaciones cuando les quitan las trancas y se permite la autorregulación.

Aquí puedes leer el texto completo de AI as Normal Technology

Esta es la liga a la primera parte de este análisis.

Escúchalo también en Spotify: