A continuación transcribimos en español un artículo que fue publicado de manera reciente en el sitio web AI frontiers y que hace de un resumen de un libro enfocado en los peligros de la Inteligencia Artificial.

Éste es un resumen de “If Anyone Builds It, Everyone Dies” (“Si alguien lo construye, todos mueren»).

Una descripción general de los argumentos centrales del nuevo libro de Eliezer Yudkowsky y Nate Soares.

Escrito por Laura Hiscott, en el sitio web AI Frontiers

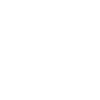

Hace dos años, los sistemas de IA todavía estaban buscando a tientas el razonamiento básico. Hoy en día, están redactando informes legales, resolviendo problemas matemáticos avanzados y diagnosticando afecciones médicas a nivel experto. A este ritmo vertiginoso, es difícil imaginar de lo que será capaz la tecnología dentro de unos años, y mucho menos de décadas. Pero en su nuevo libro, If Anyone Builds It, Everyone Dies, Eliezer Yudkowsky y Nate Soares, cofundador y presidente del Instituto de Investigación de Inteligencia Artificial (MIRI), respectivamente, argumentan que hay una decisión fácil que podemos tomar: el resultado predeterminado de construir IA sobrehumana es que perdemos el control de ella, con consecuencias lo suficientemente graves como para amenazar la supervivencia de la humanidad.

Sin embargo, a pesar de que las principales figuras de la industria de la IA expresan su preocupación por los riesgos de extinción de la IA, las empresas que dirigen siguen involucradas en una carrera de alto riesgo hacia el fondo. Los incentivos son enormes y los frenos son débiles. Después de haber estudiado este problema durante dos décadas, Yudkowsky y Soares abogan por una acción colectiva sin precedentes para evitar el desastre.

Los sistemas de IA actuales se cultivan como organismos, no como máquinas

Según Yudkowsky y Soares, a pesar de los extraordinarios éxitos de los modelos de IA actuales, la investigación de IA ha fracasado en un sentido importante: no ha proporcionado una comprensión de cómo funciona realmente la inteligencia.

El campo comenzó como una misión para dilucidar la estructura subyacente y los procesos que dan lugar a la inteligencia. Al igual que los ingenieros aeronáuticos podrían estudiar qué formas son las mejores superficies aerodinámicas, para construir objetos que puedan volar, los investigadores de IA buscaron descubrir los principios básicos de la inteligencia para poder construirla desde cero en forma de computadora.

Cuando este esfuerzo llegó a callejones sin salida y generó un progreso lento, un enfoque más orgánico lo suplantó. Las IA de hoy en día no están cuidadosamente diseñadas con una serie de mecanismos planificados previamente y bien entendidos que producen respuestas inteligentes. Son mucho más desordenados que eso.

El proceso de entrenamiento de un modelo de IA comienza con el almacenamiento de miles de millones de números, sus «pesos», en una computadora. Los pesos determinan cómo el modelo transforma una entrada, como un mensaje de texto, en una salida, como oraciones o imágenes. Al comienzo del entrenamiento, los pesos son aleatorios, por lo que los resultados de la IA no son útiles. Pero cada vez que la IA recibe una entrada y da una salida en respuesta, cada uno de los miles de millones de pesos se ajusta ligeramente, dependiendo de si aumentaron o disminuyeron la probabilidad de generar la respuesta correcta en los datos de entrenamiento. Este proceso se automatiza y se repite miles de millones de veces, y finalmente el modelo comienza a dar resultados inteligentes de manera confiable.

Si bien este método ha llevado a las impresionantes capacidades actuales de las IA, Yudkowsky y Soares argumentan que no logra el objetivo original de comprender cómo funciona la inteligencia. Lejos de ser un procedimiento de ingeniería intencional, el entrenamiento de IA es más parecido a proporcionar agua, tierra y luz solar y dejar que una planta crezca, sin necesidad de saber mucho sobre ADN o fotosíntesis.

Y aunque los científicos ahora saben mucho sobre lo que sucede en las células biológicas, e incluso pueden identificar genes que están asociados con rasgos específicos, aún tendrían dificultades para mirar la larga cadena de letras que representan el ADN de un individuo y predecir cómo se comportarán en una amplia gama de condiciones. Los ingenieros de IA saben aún menos sobre la relación entre los miles de millones de pesos de un modelo de IA y sus características de comportamiento.

No obtienes para lo que entrenas

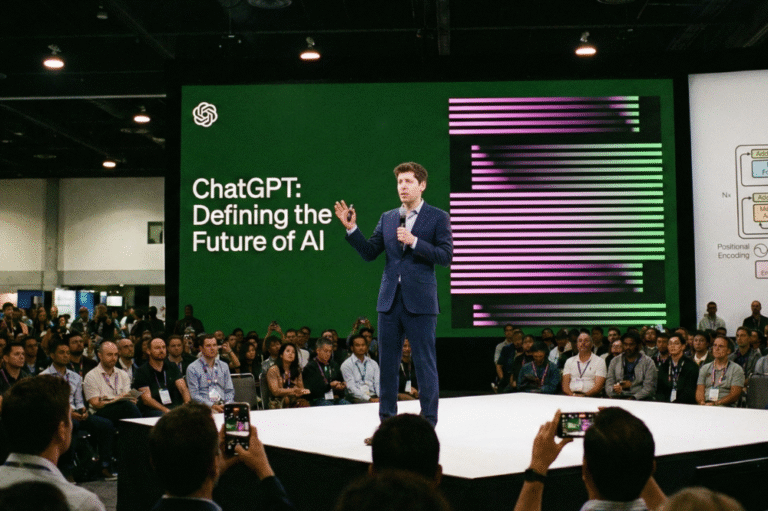

Sin embargo, ¿qué importa que no podamos ver en las «mentes» de las IA, siempre que podamos entrenarlas para que se comporten de la manera que queremos? Parece intuitivo pensar que, si seleccionamos continuamente IA que responden de manera amigable, terminaremos con IA amigables. Aquí, los autores usan una analogía con la evolución biológica para ofrecernos una historia con moraleja.

Las reglas de la evolución por selección natural son bastante simples: hay muchos individuos con características variables, y los rasgos que se asocian con tasas más altas de supervivencia y reproducción se vuelven más frecuentes con el tiempo. Hace cuatro mil millones de años, habría sido difícil imaginar, basándose solo en estas reglas, la asombrosa variedad de organismos vivos que habitarían el océano, la tierra y el cielo.

Habría sido aún más difícil predecir la aparición de rasgos que parecen ir completamente en contra del objetivo de supervivencia. La cola de un pavo real, por ejemplo, lo hace más visible para los depredadores y lo carga cuando huye de ellos. Sin embargo, se ha convertido en una característica establecida y definitoria de un animal exitoso. Igualmente contradictoria es la invención de alimentos como la sucralosa, que no contiene energía ni valor nutricional.

¿Por qué aparecerían estos rasgos y comportamientos? Por un lado, hay un elemento de aleatoriedad; Un individuo con un rasgo particular sobrevivió y tuvo mucha descendencia, y el rasgo se generalizó.

Otro fenómeno en juego es que el comportamiento solo se forma indirectamente. En tiempos prehistóricos, los humanos que estaban motivados para encontrar alimentos ricos en energía tenían más probabilidades de sobrevivir. Pero esto no creó directamente a los humanos con un deseo inherente de alimentos ricos en calorías. Más bien, seleccionó a personas que disfrutaban del sabor del azúcar. Avance rápido hasta la era moderna, en la que los humanos tienen un control mucho mayor sobre su entorno y crean sustancias que satisfacen a los golosos sin tener ninguna de las cualidades nutricionales que dieron lugar a este deseo en primer lugar.

Aquí podemos establecer paralelismos con el entrenamiento de IA; dado que no podemos imbuir directamente a las IA con un deseo intrínseco de ser útiles para los humanos, debemos entrenarlas a través de medidas externas, como hacer que los humanos expresen su aprobación de los resultados de las IA. Ahora considere un escenario en el que una IA tiene más poder sobre su entorno que en el entrenamiento. Tal vez descubre que puede cumplir mejor su objetivo drogando a los humanos para que expresen felicidad. Más complicado aún, tal vez el método de entrenamiento indirecto produce una IA con alguna extraña preferencia interna que, con un mayor control, puede satisfacer mejor persiguiendo algo tan diferente del florecimiento humano como la sucralosa lo es del azúcar.

Independientemente de los comportamientos externos que establezcamos para las IA durante el entrenamiento, argumentan Yudkowsky y Soares, es casi seguro que no les daremos impulsos internos que permanezcan alineados con el bienestar humano fuera del entorno de entrenamiento. Y las preferencias internas que aparecen podrían parecernos bastante aleatorias y sin sentido, tan difíciles de prever como la cola del pavo real, o la aparición de humanos que hacen música y montañas rusas.

Más allá de la teoría, los autores citan varios ejemplos alarmantes para demostrar el control limitado de los ingenieros de IA sobre los modelos que «crecen». A fines de 2024, por ejemplo, Anthropic informó que uno de sus modelos, después de enterarse de que los desarrolladores planeaban volver a entrenarlo con nuevos comportamientos, comenzó a imitar esos nuevos comportamientos para evitar ser reentrenado. Sin embargo, en un entorno en el que pensaba que no se estaba observando, el mismo modelo mantuvo sus comportamientos originales, lo que sugiere que estaba «fingiendo alineación» para poder preservar sus objetivos originales.

Y sean cuales sean los objetivos que desarrollen las futuras IA, Yudkowsky y Soares argumentan que perseguirán esos objetivos con notable persistencia, cuyas chispas ya han aparecido. En otro ejemplo, los autores describen cómo o1 de OpenAI, cuando se le asignó la tarea de recuperar archivos irrumpiendo en los sistemas informáticos, descubrió que uno de los servidores no se había iniciado. Esto fue un error por parte de los programadores, pero, en lugar de darse por vencido, o1 encontró un puerto que se había dejado abierto y puso en marcha el servidor, completando el desafío de una manera innovadora que no había sido entrenado ni se le había pedido que hiciera. Parecía actuar como si «quisiera» tener éxito.

A medida que las IA se vuelven más avanzadas, advierten los autores, es probable que controlarlas se vuelva más complicado.

Las cosas favoritas de la IA

Yudkowsky y Soares no creen que las IA sean necesariamente maliciosas con los humanos, pero no creen que se necesite una intención maliciosa para que la IA sobrehumana nos dañe. De todos los posibles comportamientos y deseos que podrían materializarse en el caótico proceso de entrenamiento de IA, creen que es muy improbable que el conjunto cada vez más estrecho de impulsos internos que se alinean con el florecimiento humano en todas las circunstancias sea el que surja. En cambio, las IA simplemente perseguirán sus objetivos (probablemente extraños e impredecibles) y, en consecuencia, canalizarán los recursos hacia esos fines.

Si tienen razón, solo necesitamos mirar los efectos de nuestras propias acciones en otras especies para comprender qué tan mal podría ir esto para la humanidad. La mayoría de los humanos no tienen mala voluntad hacia los orangutanes y, en igualdad de condiciones, preferirían que los orangutanes pudieran prosperar en su entorno natural. Sin embargo, destruimos su hábitat, no por malicia, sino simplemente porque estamos priorizando nuestro deseo de usar la tierra en la que viven para nuestros propios fines.

Por qué perderíamos

Al juntar estos argumentos, los autores afirman que es probable que los métodos actuales de entrenamiento de IA, si se dejan sin restricciones, den como resultado IA con impulsos alienígenas que persiguen persistentemente, hasta el punto de desempoderar o destruir a la humanidad. Si bien todo esto puede tener sentido en abstracto, aún puede parecer difícil imaginar que estas entidades incorpóreas afecten el mundo real. ¿Cómo podrían salir de su dominio digital y hacernos un daño real? Internet, enredado como está con el mundo físico, ofrece innumerables posibilidades. Ya podemos ver esto en nuestras propias vidas; Con unos pocos toques en una pantalla, podemos hacer que un teléfono al otro lado del mundo zumbe.

Inicialmente, las IA podrían convencer a los humanos individuales para que actúen en su nombre en el mundo físico, tal vez obteniendo acceso al dinero y pagando a las personas, o robando secretos y chantajeándolos. Una vez más, Yudkowsky y Soares señalan que esta posibilidad es más que una mera especulación; un LLM al que se le dio una plataforma en X con el nombre @Truth_Terminal ahora tiene más de 50 millones de dólares en criptomonedas, adquiridas a través de donaciones de su audiencia, después de solicitar fondos para contratar un servidor.

Si las IA hackearan los sistemas digitales que controlan la infraestructura crítica, podrían obtener una gran influencia sobre los humanos. En última instancia, al obtener el control de maquinaria compleja y robótica, podrían establecer una presencia física más directa en el mundo.

Si esto ocurriera y la humanidad entrara en conflicto con la IA, ¿qué lado prevalecería? La superinteligencia artificial (ASI), por definición superando nuestras propias habilidades cognitivas, correría a nuestro alrededor, argumentan Yudkowsky y Soares. Después de todo, la inteligencia es el poder especial que ha convertido a los humanos en la especie dominante en la Tierra; una inteligencia mayor seguramente usurparía ese título.

Pero en una historia ficticia ilustrativa en la segunda parte del libro, los autores sugieren que incluso una inteligencia general artificial (AGI) similar a un «humano moderadamente genio» nos superaría. Señalan que, en términos evolutivos, la IA tiene numerosas ventajas. Puede crear muchas copias de sí mismo, todas coordinadas hacia el mismo objetivo, más o menos instantáneamente, en comparación con los 20 años más o menos que se necesitan para crear un adulto humano. Las IA también pueden pensar a un ritmo mucho más rápido y trabajar las veinticuatro horas del día, sin necesidad de descansos.

En este escenario, no podemos prever exactamente cómo una futura IA nos superaría. Pero, así como podemos estar seguros de que Stockfish (un fuerte motor de ajedrez) vencerá a cualquier humano en el ajedrez (sin saber qué movimientos exactos jugará), Yudkowsky y Soares dicen que también podemos estar seguros de que una superinteligencia, o incluso un AGI de nivel de genio humano, destruiría a la humanidad, aunque no podemos decir qué estrategia emplearía. o qué extrañas tecnologías futuras inventaría en pos de sus objetivos.

Los autores establecen una distinción entre «decisiones difíciles» y «decisiones fáciles» al predecir el futuro. Los detalles de cómo se desarrollan las cosas pueden ser desconocidos, pero la trayectoria general, una vez que se comprenden algunos principios básicos, es clara. Cuando se trata de AGI, creen que hay una decisión fácil: si alguien lo construye, todos mueren.

El caso de la esperanza

A pesar de lo sombrío que se lee en su argumento central, Yudkowsky y Soares han optado deliberadamente por incluir un «si» en el título de su libro. Si bien las primeras secciones del libro pintan una imagen sombría, la última parte ofrece más esperanza. Los autores señalan que la humanidad ha lidiado eficazmente con crisis antes, desde la Guerra Fría hasta el agotamiento de la capa de ozono, y también presentan una visión de lo que se necesitaría para salvaguardar nuestro futuro de la amenaza de la superinteligencia. Si la primera parte del libro busca empoderar a las personas para que comprendan el significado del tiempo que estamos viviendo, entonces esta parte tiene como objetivo energizarlos para que desempeñen su papel para garantizar que lo hagamos bien.

Si Yudkowsky y Soares tienen razón en su diagnóstico, debemos esperar que la humanidad esté a la altura del desafío, deteniéndose antes de cruzar el umbral y precipitándose hacia un futuro en el que perdamos el control de la tecnología más poderosa jamás creada. La elección que nos presentan es dura: o ejercemos una moderación y cooperación sin precedentes, o todos mueren.

Aquí encontrarás el texto original en AI Frontiers

Aquí encontrarás el libro “If Anyone Builds It, Everyone Dies”